一、 准备工作

在开始之前,请确保你已准备好以下基础条件:

- API 密钥:你需要至少一个 AI 服务商的 API Key(如 OpenAI, Anthropic, 或 Google Gemini)。

- 推荐:使用 OpenAI 兼容格式的接口(如阿里云百炼、DeepSeek)以降低成本。

- Docker 环境:建议安装 Docker Desktop(Windows/Mac)或 Docker Engine(Linux)。

- 硬件要求:至少 4GB 内存(若运行本地模型如 Ollama,则需要更高配置的 GPU/内存)。

- 项目地址:lfnovo/open-notebook: An Open Source implementation of Notebook LM with more flexibility and features

二、 快速部署方案 (Docker)

这是最推荐的安装方式,适合绝大多数用户。

1. 创建项目目录

在你的电脑上创建一个文件夹:

mkdir open-notebook && cd open-notebook

2. 编写 docker-compose.yml

在该目录下创建一个名为 docker-compose.yml 的文件,并粘贴以下内容(以单容器版本为例):

services:

surrealdb:

image: surrealdb/surrealdb:v2

command: start --user root --pass password --bind 0.0.0.0:8000 rocksdb:/mydata/mydatabase.db

ports:

- "8000:8000"

volumes:

- ./surreal_data:/mydata

open_notebook:

image: lfnovo/open_notebook:v1-latest

pull_policy: always

ports:

- "8502:8502" # Web UI

- "5055:5055" # API

environment:

- OPENAI_COMPATIBLE_BASE_URL=你代理商的url

- OPENAI_COMPATIBLE_API_KEY=你的API_KEY

# Database

- SURREAL_URL=ws://surrealdb:8000/rpc

- SURREAL_USER=root

- SURREAL_PASSWORD=password

- SURREAL_NAMESPACE=open_notebook

- SURREAL_DATABASE=open_notebook

volumes:

- ./notebook_data:/app/data

depends_on:

- surrealdb

restart: always

3. 启动容器

在终端运行命令:

#上述的key和baseurl修改完成后,运行下述命令即可

docker compose up -d

启动完成后,在浏览器访问 http://localhost:8502 即可进入界面。

environment: 该项目内嵌了各大ai代理商的url,如果使用各大代理商的话,可以直接设置key,即可,环境key设置名称如下:

1. 主流 AI 厂商原生接口

这些是各大模型厂商的标准配置项,直接填入申请到的 API Key 即可。

- OpenAI

:OPENAI_API_KEY=你的sk-key - Anthropic (Claude)

:ANTHROPIC_API_KEY=你的key - Google Gemini (推荐:处理长文档和播客效果最佳)

:GOOGLE_API_KEY=你的key GEMINI_API_BASE_URL= # 可选:用于中转或 Vertex AI 代理 - DeepSeek (深度求索)

:DEEPSEEK_API_KEY=你的key - Mistral

:MISTRAL_API_KEY=你的key - Groq (极速推理)

:GROQ_API_KEY=你的key - xAI (Grok)

:XAI_API_KEY=你的key

2. 多模型中转与兼容平台

如果你使用的是第三方中转代理,或者国内厂商(如阿里云百炼、月之暗面)提供的兼容接口,请使用以下格式:

OpenRouter:

OPENROUTER_BASE_URL="https://openrouter.ai/api/v1" ,

OPENROUTER_API_KEY=你的key.

通用 OpenAI 兼容接口 (Generic)OPENAI_COMPATIBLE_BASE_URL=http://代理商地址/v1 ,OPENAI_COMPATIBLE_API_KEY=你的key.

3. 分模式高级配置(推荐)

Open Notebook 允许你根据功能(对话、向量、语音)分别设置不同的代理商。这是最灵活的配置方式,可以让你用最便宜的厂商做向量,用最强的厂商做对话。

- 用于聊天对话 (LLM)

:OPENAI_COMPATIBLE_BASE_URL_LLM=http://地址/v1 ,OPENAI_COMPATIBLE_API_KEY_LLM=你的key. - 用于语义搜索 (Embedding)

:OPENAI_COMPATIBLE_BASE_URL_EMBEDDING=http://地址/v1 ,OPENAI_COMPATIBLE_API_KEY_EMBEDDING=你的key. - 用于音频转录与播客 (STT/TTS)

:OPENAI_COMPATIBLE_BASE_URL_STT=http://地址/v1 ,OPENAI_COMPATIBLE_API_KEY_STT=你的key ,OPENAI_COMPATIBLE_BASE_URL_TTS=http://地址/v1 ,OPENAI_COMPATIBLE_API_KEY_TTS=你的key.

4. 本地模型与企业级服务

- Ollama (本地私有部署)

OLLAMA_API_BASE="http://你的内网IP:11434"- Azure OpenAI (微软企业版)

AZURE_OPENAI_API_KEY=你的key AZURE_OPENAI_ENDPOINT=你的终结点地址 AZURE_OPENAI_API_VERSION=2024-12-01-preview

5. 辅助功能 Key

除了大模型,Open Notebook 还需要一些辅助工具来实现网页爬取和播客生成:

- 网页爬取 (Firecrawl/Jina)

:FIRECRAWL_API_KEY=你的key JINA_API_KEY=你的key - 播客专用语音 (ElevenLabs):

ELEVENLABS_API_KEY=你的key - 向量搜索优化 (Voyage AI)

:VOYAGE_API_KEY=你的key

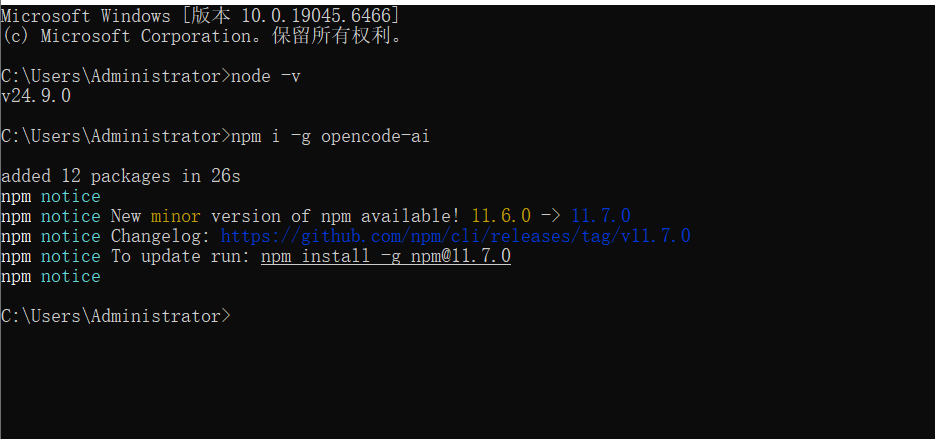

三、 开发者部署方案 (Conda/源码)

如果你希望进行二次开发或自定义功能,可以使用源码安装。

克隆仓库:

git clone https://github.com/lfnovo/open-notebook.git

cd open-notebook创建 Conda 环境:

conda create -n open-notebook python=3.11 -y

conda activate open-notebook

conda install -c conda-forge uv nodejs -y

uv sync启动服务: 使用项目自带的 Makefile 一键启动所有服务(包括数据库、API 和前端):

make start-all注意:此模式下前端地址通常为 http://localhost:3000。

四、 核心配置与使用指南

1. 模型分配 (Model Assignments)

进入系统后,首先点击左侧的 Settings 或 Models 进行模型绑定:

- Chat Model:用于对话,推荐逻辑强的模型。

- Embedding Model:必需。用于文档的语义搜索,推荐使用

text-embedding-v4。 - TTS Model:用于生成播客语音。

2. 创建笔记本与添加素材

- 点击 + Create Notebook 创建一个新的研究项目。

- 点击 Add Source 上传素材。支持 PDF, DOCX, TXT, MD 甚至 YouTube 链接。

- 上传后,系统会自动对文档进行向量化处理(Embedding)。

3. AI 对话与 RAG 检索

在右侧的聊天窗口提问。AI 会基于你上传的“知识库”内容进行回答,并标注信息来源。

4. 转换功能 (Transformations)

Open Notebook 提供预设的指令模板(如生成摘要、提取关键词、生成测验)。你也可以在 Transformations 菜单中创建自定义的 Prompt 模板,针对所有文档一键生成结果。